Bestemming deze week aangekondigd een nieuw model van kunstmatige intelligentie (AI) open (bron) het koppelen van meerdere gegevenstypen, waaronder tekst, audio, visuele gegevens, temperatuur- en bewegingsmetingen. Het model is momenteel slechts een onderzoeksproject, zonder directe praktische of consumententoepassingen. Het wijst echter op een toekomst van systemen generatieve kunstmatige intelligentie die in staat is om meeslepende ervaringen te creëren en multisensorisch. Zijn naam is Meta ImageBind en we leggen uit hoe het werkt.

Meta introduceert ImageBind, een nieuw open source multi-sensorisch AI-model. Hier is hoe het werkt en wat het kan doen

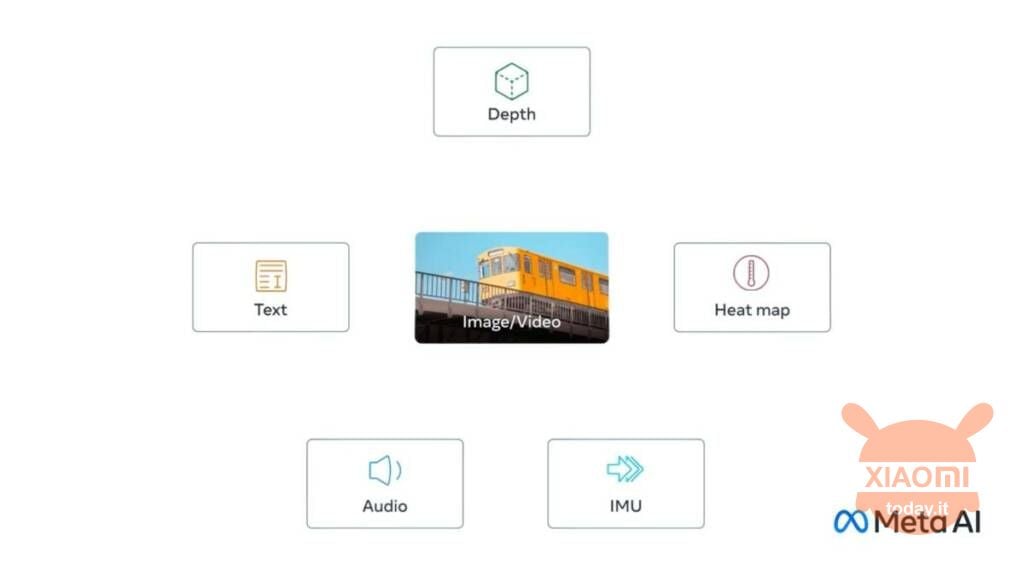

De nieuwigheid heet Meta ImageBind en is de eerste combineer zes soorten gegevens in een enkele multidimensionale ruimte. De zes gegevenstypen die in het model zijn opgenomen, zijn:

- Visuals (in de vorm van afbeeldingen en video's)

- Thermisch (infraroodbeeldvorming)

- Teksten

- Audio

- Diepgaande informatie

- Bewegingsmetingen gegenereerd door een traagheidsmeeteenheid of IMU

Zie ook: Meta introduceert SAM, de AI die individuele elementen binnen afbeeldingen identificeert

Het idee is dat toekomstige AI-systemen dat kunnen kruisverwijzing naar deze gegevens op dezelfde manier als de huidige systemen doen voor tekstinvoer. Stel je bijvoorbeeld een futuristisch virtual reality-apparaat voor dat niet alleen audio- en visuele input genereert, maar ook onze omgeving en onze beweging op een fysiek podium. De gebruiker kan de tool vragen om boots een lange zeereis na, en zou hem niet alleen op een schip zetten met het gebulder van de golven op de achtergrond, maar ook met het wuivende dek onder de voeten en de koele bries van de zeelucht. Het idee is dat het platform verschillende dataformaten combineert om het resultaat te genereren.

In een blogpost merkt Meta dat op andere sensorische inputstromen kunnen worden toegevoegd naar toekomstige modellen, waaronder "tast-, spraak-, reuk- en fMRI-hersensignalen“. Deze nieuw uitgebrachte functie is nog niet klaar, dus de community kan het in dit vroege stadium niet testen, ook al bevindt het zich in een vergevorderd stadium van ontwikkeling.